Un consorzio statunitense guidato dall'azienda Oracle ha acquisito il controllo delle attività di TikTok negli USA. L'accordo, ufficialmente, mira a garantire la sicurezza dei dati americani (dalla censura e influenza cinese), con Oracle che gestisce l'infrastruttura e l'algoritmo.

Dopo pochi giorni, però, è emerso che TikTok USA censura le ricerche della parola "Epstein" (link), l'imprenditore arrestato per abusi sessuali e traffico internazionale di minori, morto nel 2019, con cui Donald Trump aveva rapporti stretti.

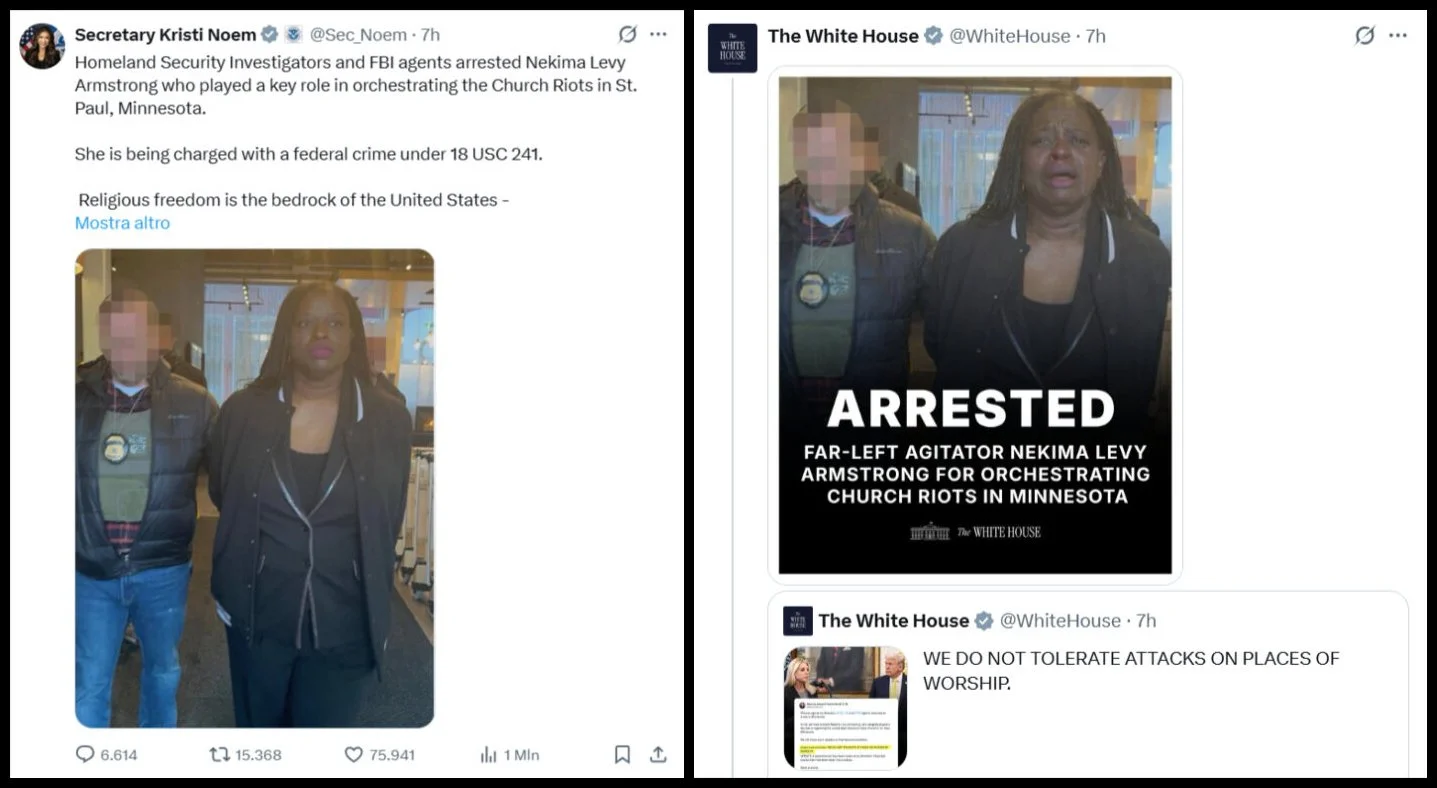

Inoltre è in atto una censura di persone che criticano il governo (link), come nel caso di una giornalista con 200.000 follower i cui contenuti negli ultimi giorni non hanno avuto visualizzazioni.

Anche l’engagement dei video sulle proteste di Minneapolis è in calo sulla piattaforma.

Più in generale, il panorama relativo al controllo dei social media e dei media tradizionali è preoccupante:

Larry Ellison, tramite Oracle, influenza TikTok USA.

Elon Musk possiede X, Grok e Grokipedia.

Mark Zuckerberg guida Meta Platforms, controllando quindi Facebook, Instagram, WhatsApp, Messenger e Meta AI.

Sam Altman guida OpenAI e ChatGPT.

Alphabet controlla Google, YouTube e Gemini.

La famiglia Murdoch detiene Fox News, il Wall Street Journal e il New York Post.

Jeff Bezos possiede il Washington Post, Amazon Prime Video e Twitch.

Si tratta di oligarchi del settore tecnologico e dell'informazione che, in misura diversa, gravitano nell’orbita di Trump (o che si sono piegati rapidamente al suo potere) e che oggi controllano i principali canali attraverso cui ci informiamo, delegandogli sempre più spesso il compito di selezionare, riassumere e interpretare ciò che accade nel mondo.

Chi controlla i social media e i sistemi di intelligenza artificiale (IA) ha il potere di stabilire quali narrazioni diventano dominanti e quali, invece, vengono marginalizzate o rese invisibili. In questo contesto, il giornalismo tradizionale rischia di perdere rilevanza e visibilità (come analizzo nel mio articolo “L’intelligenza artificiale salverà il giornalismo?”) perché l’IA e le piattaforme social ne saccheggiano i contenuti, erodendo audience e modelli economici. Una quota crescente di pubblico non cerca più attivamente informazioni ma le assorbe passivamente dai social o affida all’IA il compito di filtrarle, sintetizzarle e interpretarle, eliminando di fatto la necessità di consultare le fonti originali.

Per i regimi autoritari, il controllo delle narrazioni che alimentano il dibattito pubblico è un obiettivo strategico (come abbiamo visto, la recente uccisione di Alex Pretti, un infermiere di Minneapolis di 37 anni, sembra aver colpito in modo pesante la narrazione di ICE, spingendo Trump a fare qualche passo indietro). L’amministrazione americana sta rafforzando il controllo sulle infrastrutture che le veicolano, che è un passaggio decisivo per acquisire la capacità di orientare o persino riscrivere la realtà.